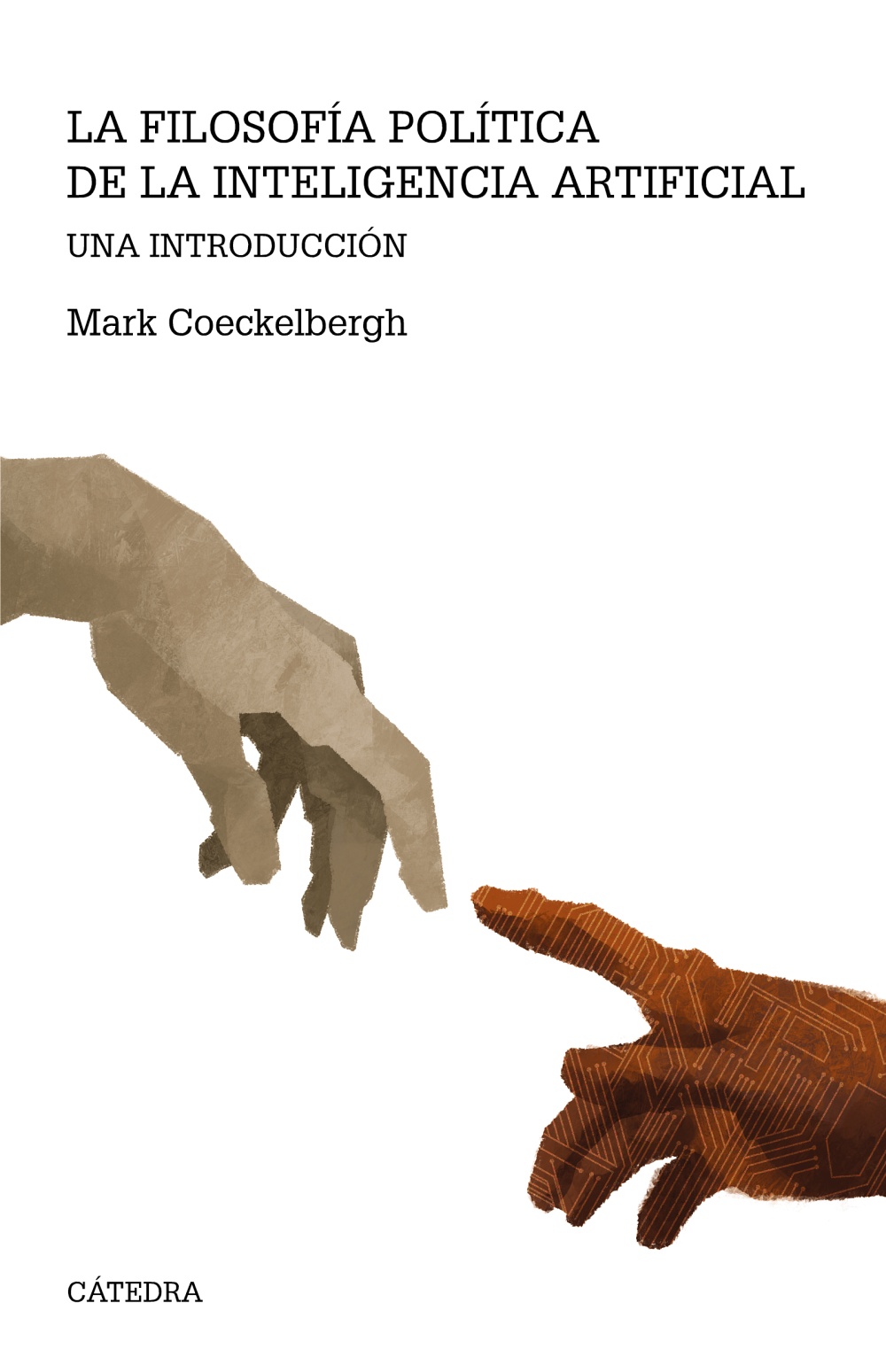

El pensador belga Mark Coeckelbergh (Lovaina, 1975), profesor de Filosofía de la Tecnología en la Universidad de Viena, acaba de publicar Filosofía política de la inteligencia artificial (Cátedra), un manual para hacer frente a todos los desafíos que plantea el imparable desarrollo tecnológico.

Pregunta. ¿Qué opina de la carta de los expertos que piden una pausa de seis meses para la IA?

Respuesta. No estoy de acuerdo con su contenido. Para mí, esta carta encaja con una exageración transhumanista de la IA y una narrativa a largo plazo que no comparto. No creo que la IA vaya a evolucionar hasta convertirse en una superinteligencia ni que debamos centrarnos en un futuro lejano. Tenemos que fijarnos en la ética y centrarnos en los riesgos de ahora. No necesitamos ciencia ficción. También es cuestionable que una moratoria tenga sentido porque la gente sabrá cómo burlarla.

-

P. ¿Cuáles son los riesgos más inmediatos?

-

R. Inteligencias como ChatGPT recogen información de internet y esa información no siempre es exacta. El funcionamiento del programa también puede dar lugar a mezclas de información falsa o engañosa. La IA también puede utilizarse para manipular y a la vez puede llegar a ser muy manipuladora: a través de sus respuestas puede persuadir a la gente para que haga cosas. En Bélgica ha habido un caso de un chatbot que persuadió a alguien para que acabara con su vida. Se trata de riesgos graves e inminentes.

-

P. En términos de ética, ¿cuál es el mayor dilema que plantean los avances en IA?

-

R. Hay que elegir entre funcionalidad y poner límites éticos. Es bueno regular y restringir este tipo de IA. Pero, ¿hasta qué punto sigue siendo funcional si, por ejemplo, se filtran determinadas opiniones en nombre de la corrección política? ¿Hasta qué punto está justificado ese tipo de censura y quién debe tomar las decisiones al respecto? Actualmente, un gran problema es que el desarrollo de la IA está en manos de unas pocas grandes empresas y eso no es democrático.

-

P. La carta de los expertos dice que la IA puede cambiar la historia de la vida en la Tierra...

-

R. Como otras grandes tecnologías, la IA tendrá un enorme impacto en la sociedad, pero la carta exagera.

-

P. ¿Es realmente posible que los humanos perdamos el control de nuestra civilización?

-

R. El miedo a la pérdida de control y al caos ha ocurrido siempre. No hay pérdida de control cuando se regula adecuadamente esta tecnología. La pérdida de control que debería preocuparnos es que la IA siga en manos de las grandes tecnológicas y que su futuro esté influido por las personas que firmaron la carta. Son parte del problema, no de la solución... Necesitamos una IA democrática y una moratoria no es la mejor forma de abordar estos problemas. Necesitamos una regulación y más investigación sobre la ética y asegurarnos de que el uso de la inteligencia artificial por parte del Estado no conduzca a más autoritarismo y opresión.

-

P. ¿Quién debería auditar los avances del sector y qué papel deberían desempeñar entonces los Gobiernos en esta situación?

-

R. Necesitamos auditorías independientes y los Gobiernos deberían tomar medidas: no una moratoria, sino un marco sólido de regulación y más inversión en investigación independiente sobre el impacto ético y político de la IA. Actualmente hay mucho trabajo en el mundo académico, pero los medios de comunicación están más interesados en lo que dice gente como Elon Musk que en mostrar los resultados de personas que están pensando en estos temas desde hace años.

Entrevista publicada en El Mundo

SINOPSIS DEL LIBRO

A la luz del creciente desarrollo de las tecnologías y aplicaciones relativas a la inteligencia artificial, problemas acuciantes de nuestra sociedad, tales como el racismo, el cambio climático o la calidad de la democracia, cobran una mayor urgencia y una relevancia renovada. ¿Cómo avanzar en el debate político en torno a la inteligencia artificial para dejar atrás las meras advertencias y las acusaciones excesivamente fáciles? Este libro presenta, desde la perspectiva de la filosofía política, una introducción accesible a los muchos y complejos desafíos que se derivan de la implantación de IAs en nuestras sociedades e industrias, desde la discriminación judicial a las implicaciones para la democracia de una vigilancia ubicua y permanente. Un ensayo original y actualizado que interesará tanto a estudiantes e investigadores en filosofía de la tecnología y filosofía política como a especialistas en innovación, reguladores y, en general, cualquier persona interesada en el impacto sociocultural de las nuevas tecnologías.

share